Desde su aparición a mediados del siglo xx, las ciencias sensoriales han avanzado considerablemente gracias a la aportación de la neurobiología, la psicología, la psicofísica y de los nuevos métodos estadísticos. El mundo del vino ha sido desde siempre un dominio en el que la evaluación sensorial ha estado en manos de unos pocos expertos que describen, juzgan y toman decisiones individualmente. Esta situación ha ralentizado la adopción de métodos sensoriales rigurosos en sus diferentes ámbitos de aplicación; desde la producción a la comercialización e incluso a veces en proyectos de investigación.

El vino es un producto cultural complejo que ofrece multitud de elección a los consumidores. Algunos estudios recientes en ciencias del consumidor (d’Alessandro y Pecotich, 2013) muestran que los consumidores tienen una capacidad limitada para evaluar la calidad intrínseca de un vino (propiedades sensoriales del mismo). Además, como la mayoría de las situaciones de compra no permiten al consumidor catar el vino (supermercado, tienda, internet…), este debe basar su elección en signos extrínsecos de calidad, transmitidos por el envase y el etiquetado (precio, DO, peso de la botella, presencia de medalla o recomendación de guía de vinos…) (Charters y Pettigrew, 2007; Sáez-Navajas et al., 2016).

«Los concursos enológicos son una forma de orientar a los consumidores en sus elecciones gracias a la atribución de medallas de distinto valor. Algunas de estas recompensas pueden ser decisivas para guiar la elección del consumidor. Pero…»

En este contexto, los concursos enológicos son una forma de orientar a los consumidores en sus elecciones gracias a la atribución de medallas de distinto valor. Algunas de estas recompensas pueden ser decisivas para guiar la elección del consumidor (Lockshin et al., 2010; Chrea et al., 2011). De hecho, se ha demostrado en la literatura que los premios, especialmente las medallas de oro, tienen un impacto positivo en las decisiones de compra, especialmente para los consumidores con bajo nivel de implicación (Lockshin et al., 2010).

En Francia, actualmente hay 114 competiciones de vinos, entre las cuales 45 se han creado desde el año 2000. En España, también la tendencia es al aumento del número de concursos. En 2009, el BOE listaba 33 concursos reconocidos mientras que en 2016 la lista se alargaba a 45 concursos enológicos. Este aumento significativo en el número de concursos ha dado lugar a un aumento en el número y la diversidad de medallas en los puntos de venta.

Frente a esta “inflación” de medallas, ¿puede el consumidor confiar en todos estas recompensas? Las competiciones enológicas han sido objeto de varios estudios. Por ejemplo, Hodgson (2009) estudió las probabilidades de un mismo vino de ganar una medalla en uno de los 13 concursos de vinos en Estados Unidos. Los resultados mostraron que no había consenso entre las distintas competiciones sobre los vinos ganadores de medallas y que la probabilidad de ganar una medalla no era superior al azar. El mismo autor mostró que los jurados de un gran concurso de vinos, también en Estados Unidos, eran muy consensuales sobre los vinos que no les gustaban, pero mucho menos sobre los vinos que consideraban “de buena calidad” (Hodgson, 2008). Gawel y Godden (2008) mostraron que la repetitividad de los expertos no era muy buena y que se obtenía un mejor consenso cuando los vinos eran evaluados por un panel de tres expertos en comparación con una anotación individual.

«… se mostró que la repetitividad de los expertos no era muy buena y que se obtenía un mejor consenso cuando los vinos eran evaluados por un panel de tres expertos en comparación con una anotación individual.»

Desde el punto de vista metodológico, la mayoría de los concursos de vinos presentan sesgos bastante serios. Por ejemplo muchos concursos juzgan varios cientos de muestras y obviamente no puede hacer que cada experto juzgue todas esas muestras a no ser que el concurso dure prácticamente una semana (lo que por logística es muy complicado). Por ello, se crean múltiples jurados de 5 o 6 expertos (más o menos según la ambición y los objetivos del concurso en cuestión) y la atribución de una muestra a un jurado se hace de manera aleatoria. Esta organización hace surgir la cuestión esencial de la reproducibilidad de los diferentes jurados. Un “buen” vino puede verse privado de medalla al caer arbitrariamente en un jurado muy estricto, mientras que otro vino más mediocre puede obtener una medalla simplemente por haber caído en un jurado “laxista”. Actualmente muy pocos concursos controlan y dan cuenta públicamente de la reproducibilidad entre jurados.

Otro punto delicado es el orden de evaluación de las muestras. En ciencia sensorial (y en otras ciencias) se conoce el efecto del orden de evaluación desde hace mucho tiempo. Por ello se recomienda equilibrar los órdenes de presentación utilizando presentaciones aleatorias o también de tipo Latin square. Sin embargo, la OIV (2009) impone a los concursos oficiales unas reglas en ese sentido que implican que todos los jueces evalúan las muestras en el mismo orden (del más joven al más viejo, de menos a más azúcar residual, de menos a más madera). Hoy en día que nosotros sepamos ningún concurso hace lo necesario para equilibrar los efectos de orden.

En este contexto, hemos realizado un estudio durante dos ediciones de un concurso de vinos en Francia. Los objetivos fueron evaluar la reproducibilidad entre los jurados y el impacto del orden de degustación en la nota final de calidad de un vino de referencia introducido en el concurso sin el conocimiento de los jueces.

Materiales y métodos

Protocolo usual del concurso

El estudio se realizó en dos ediciones sucesivas de un concurso de vinos francés en 2012 y 2013. Este concurso recibe alrededor de 400 muestras cada año. En este concurso en particular, la región, la variedad y la añada es la misma en todas las muestras. Un centenar de catadores experimentados de Francia y de otros países (enólogos, profesionales de la viticultura, sumilleres, vendedores, etc.) se distribuyen en unos 20 jurados.

En cada jurado hay un presidente que es un enólogo de la región, su función es ayudar a otros expertos en el uso de la hoja de cata y moderar las discusiones sobre posibles desacuerdos en la anotación. Aproximadamente 20 muestras son evaluadas en dos series de 10.

Todos los vinos son identificados por un código de tres dígitos y servido monádicamente en copas transparentes INAO. No está permitido catar de nuevo las muestras ya catadas (salvo problema de olor de corcho). Una pausa de 10 a 15 minutos se realiza entre las dos series de muestras.

|

Ficha de cata La ficha de cata utilizada fue la que la OIV recomienda para vinos tintos. Tiene cuatro criterios de cata: vista, olfato, gusto y armonía. Cada criterio se desglosa según cinco niveles. Cada descriptor es ponderado de manera diferente. La nota final sobre 100 puntos se obtiene sumando las notas ponderadas de cada descriptor. Para cada vino, una nota media se calcula a partir de notas sobre 100 de cada juez del jurado considerado. La transformación o no en medalla se hace de acuerdo con la siguiente escala: – Gran Medalla de Oro: al menos 93 puntos. |

En la edición de 2012 y anteriores, antes de comenzar el concurso, un vino tinto “de calentamiento” (también llamada “muestra cero”) se cata para preparar el paladar y familiarizar a los expertos con la ficha de anotación. Este vino es comentado públicamente por uno de los organizadores del concurso dando las notas que este vino podría haber obtenido. En la edición 2013, tres vinos de calentamiento de diferentes calidades fueron propuestos a los jueces y comentados públicamente antes del comienzo de la cata oficial.

Introducción de una muestra control en el protocolo del concurso

Durante cada una de las dos ediciones, un mismo vino control fue introducido en primera y penúltima posición de la primera serie de la mañana, en todos los jurados. Este vino fue de la misma añada, variedad y región que las otras muestras del concurso. Este vino no se inscribió oficialmente, las medallas por él obtenidas fueron solo hipotéticas.

Análisis de datos

-

- Reproducibilidad entre jurados: para cada edición, los datos se analizaron mediante análisis de la varianza (ANOVA) de las notas sobre 100 de cada juez para el vino control en la primera posición así como en la penúltima posición. Un test de Newman-Keuls (a=5%) permitió comparar las notas medias de los distintos jurados para detectar cuales anotaron el vino de manera diferente.

- Efecto del orden: se realizó un test de t de Student entre las notas medias obtenidas para cada jurado de vinos en primera y penúltima posición. Seguidamente, las notas medias de todos los jurados se convirtieron en medallas de acuerdo con la escala indicada anteriormente.

Resultados

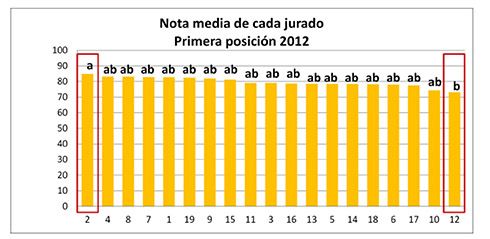

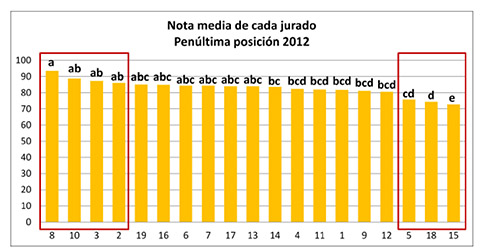

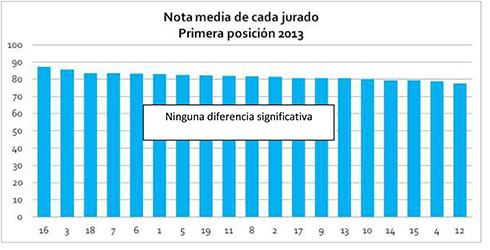

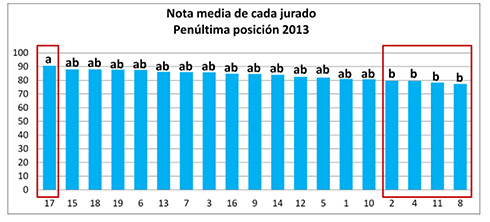

Reproducibilidad de los jurados

Las ANOVA dieron un efecto significativo del jurado para las dos posiciones de 2012 (F=2,0, p<0,05 y F=5,6, p<0,0001 para primera y penúltima posición respectivamente) y para la penúltima posición en 2013 (F=3,3, p<0,001). La primera posición de 2013 no fue afectada por el jurado. Las figuras 1 y 2 muestran las notas medias de la edición 2012 otorgadas por cada jurado al vino control en primera y penúltima posición respectivamente. Las figuras 3 y 4 muestran la misma información pero de la edición 2013.

Los resultados muestran que el efecto jurado es menor en el 2013, no solo en cuanto a significatividad estadística, sino también en diferencias de puntos entre jurados; 12 y 21 puntos de diferencia entre la nota más alta y la más baja en 2012 contra solamente 10 y 13 puntos en 2013.

Conviene mencionar que en el 2013 se añadieron tres vinos de “calentamiento” de diferentes niveles de calidad (solo uno en 2012). Estas muestras catadas antes de las muestras oficiales y comentadas públicamente por la organización han podido contribuir a una especie de calibrado común para todos los jurados y de ese modo mejorar la convergencia de anotación entre ellos.

Efecto del orden de presentación

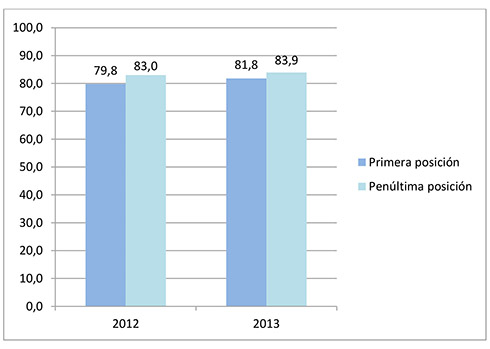

Las notas medias que el vino control recibió en 2012 y 2013 en primera y penúltima posición se presentan en la figura 5.

Las diferencias de puntuación entre la primera y la penúltima posición son significativas pero relativamente débiles: tres puntos en 2012 y solo dos en 2013. De nuevo, es posible que los tres vinos de calentamiento sean la causa de la disminución del efecto del orden en el 2013.

A continuación las notas de cada jurado se convirtieron en medallas (hipotéticamente otorgadas al vino control) aplicando los valores umbral presentados anteriormente. El resultado se resume en la tabla 1.

Aunque las diferencias en número de puntos no son muy grandes, el hecho de transformar las notas en medallas muestra el fuerte impacto de la posición en las probabilidades de medalla. Este resultado sugiere que el hecho de que los jueces sepan donde se sitúan los límites de medalla podría influenciar su manera de evaluar. En todo caso es curioso que las notas presentadas en la figura 5 estén todas justamente cerca de 81 puntos; como si hubiera una “barrera psicológica” a 81 puntos.

De hecho, la probabilidad de obtención de una medalla es multiplicada por un factor 1,9 en 2012 y 1,4 en 2013. Para 9 jueces en 2012 y 7 en 2013, el tipo de medallas no cambia. Para otros jurados, el número y el nivel de la medalla aumentan. Ello supone un porcentaje de homogeneidad entre los jueces de 47,4% en 2012 y 36,8% en 2013 sobre la concesión de medallas. Estos resultados son superiores a los presentados por Hodgson (2014) quien mostró solo un 10% de homogeneidad entre los jueces en competiciones en Estados Unidos.

Conclusiones

Nuestro estudio ha mostrado que la reproducibilidad de los jurados en el concurso objeto de estudio es bastante buena, especialmente en 2013. Ello es debido, a parte de la introducción de tres vinos de entrenamiento en 2013, y al esfuerzo de los organizadores en constituir jurados equilibrados con diferentes perfiles de jueces (enólogos, sumilleres, productores, periodistas, aficionados…).

«Hay un esfuerzo de los organizadores por constituir jurados equilibrados con diferentes perfiles de jueces (enólogos, sumilleres, productores, periodistas, aficionados…).»

Respecto al efecto del orden, los resultados son más inquietantes. Los jueces tienden claramente a otorgar más medallas al final de la serie que al principio independientemente de la calidad intrínseca del vino. La razón puede ser el hecho que los jueces construyen sus referencias internas al principio de la serie y no osan otorgar medallas. Es una actitud más bien conservadora que no puede ser corregida ya que las normas del concurso no permiten redegustar los vinos para afinar las notas. Los vinos de entrenamiento previos a la cata oficial disminuyen el problema, pero no lo eliminan.

Este trabajo ha puesto de manifiesto la necesidad de reconsiderar el protocolo clásico de los concursos de vinos con el fin de eliminar o disminuir los sesgos potenciales y reales. Los principales obstáculos a la mejora del protocolo de cata son claramente logísticos y económicos. No hay que olvidar que los concursos enológicos no solo tienen como objetivo un supuesto servicio al consumidor, sino que también juegan un papel promocional y económico importante.

¿Para cuándo el concurso perfecto?

Bibliografía

. Lockshin L, Wade J, d’Hauteville F, Perrouty JP: Using simulations from discrete choice experiments to measure consumer sensitivity to brand, region, price, and awards in wine choice. Food Quality and Preference 2006; 17: 166-78.

. Sáenz-Navajas MP, Ballester J, Fernández-Zurbano P, Ferreira V, Peyron D, Valentin D: Wine Quality Perception: a Sensory Point of View. (Chapter 6) In: Wine safety, consumer preference and human health. Victoria Moreno-Arribas, Begona Bartolomé-Sualdea, eds. Springer International Publishing, 2016: 119-38.

. Charters S, Pettigrew S: The dimensions of wine quality. Food Quality and Preference 2007; 18: 997-1007.

. Hodgson RT: An Analysis of the Concordance Among 13 U.S. Wine Competitions. Journal of Wine Economics 2009; 4, Issue 1, Spring: 1-9.

. Hodgson RT: An Examination of Judge Reliability at a major U.S. Wine Competition. Journal of Wine Economics 2008, 3, Issue 2: 105-13.

. Gawel R, Godden PW: Evaluation of the consistency of wine quality assessments from expert wine tasters. Australian Journal of Grape and Wine Research 2008, 4, Issue 1, 1-8.

. Organisation Internationale de la Vigne et du Vin : Norme OIV des concours internationaux de vins et de boissons spiritueuses d’origine vitivinicole. OIVCONCOURS332A–2009, 2009.

. D’Alessandro S, Pecotich A: Evaluation of wine by experts and novice consumers in the presence of variations in quality, brand and country of origin cues. Food Quality and Preference 2013; 28 (1): 287-303.

. Chrea C, Melo L,Evans G, Forde C, Delahunty C, Cox DN: An investigation using three approaches to understand the influence of extrinsic product cues on consuler behavior: an exemple of Australian wines. Journal of Sensory Studies 2011; 26 (1): 13-24.